meta에서 공식으로 풀어준 llama3 말고도 사람들이 튜닝? 같은걸해서 여러 버전으로 특화해 놓은게 있다. 그중에서도 한국어 잘 알아먹게

데이터 넣어주시고 여러모로 잘 말아주셔서? 공개해주신 감사한 분들이 있음

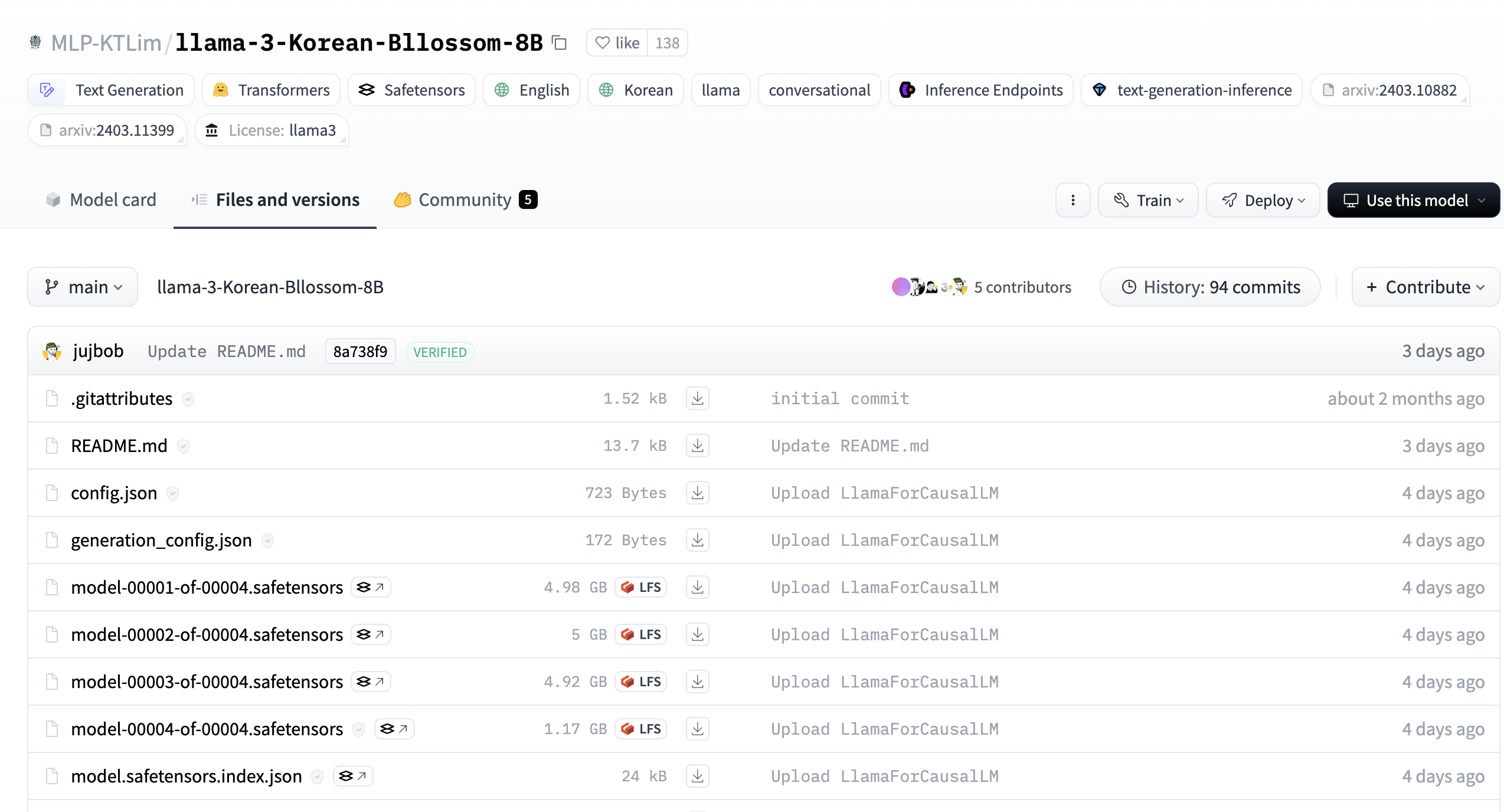

https://huggingface.co/MLP-KTLim/llama-3-Korean-Bllossom-8B/tree/main

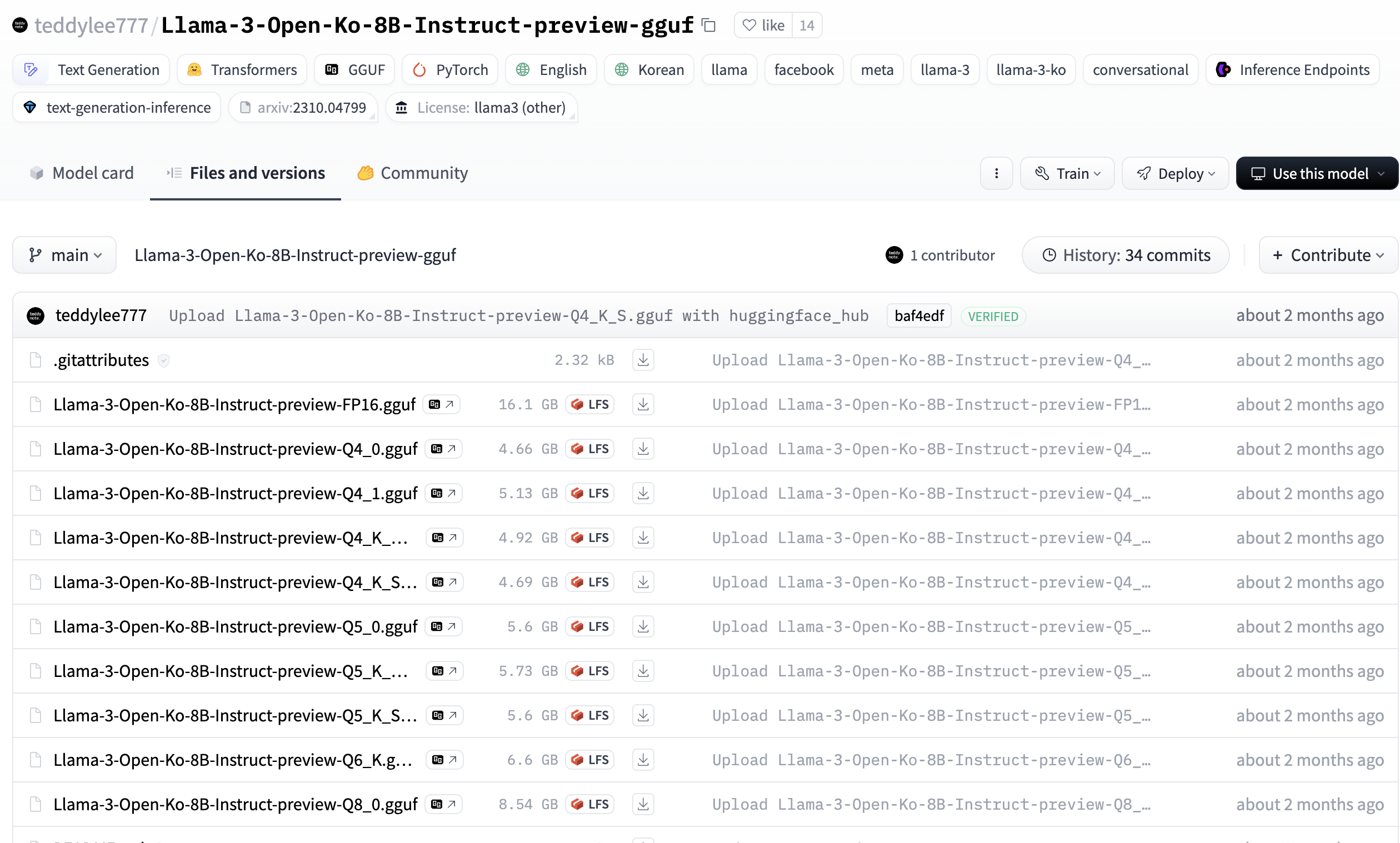

https://huggingface.co/teddylee777/Llama-3-Open-Ko-8B-Instruct-preview-gguf

대표적으로 이 두개가 있는데 아래것을 사용해보도록하자. 왜냐하면 .gguf 확장자로 되어있어야 어케저케해서 모델로 잘 만드는데

이미 그렇게 되어있기 때문이다. 첫번째 링크것처럼 safetensors 확장자로 되어있으면 다시 gguf로 변환해주는 작업이 필요하다고한다.

1.모델파일 다운로드

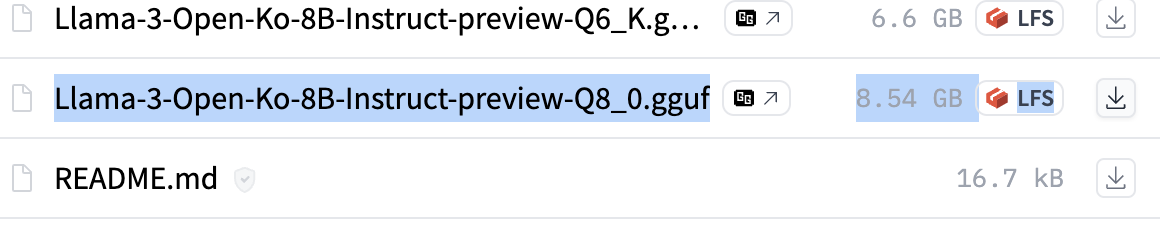

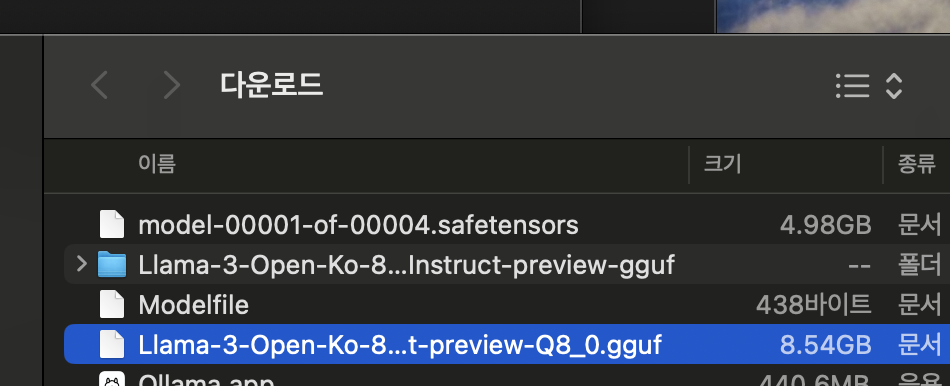

깃허브처럼 pull해서 받아도되지만 그냥 파일 하나만 딸랑 받아도된다. 저 각각의 gguf를 다 받을 필요는 없고 하나만 받으면 되는거같은데

8.54기가짜리 하나만 받아서 해보았다.

2.다운로드 폴더 확인

아래와같이 다운로드 받아지면 Modelfile을 하나 만들어주면된다. 이 모델파일이 다른게 아니라 확장자도 없고 그냥 Modelfile이다

아무 text편집기로 만들어주고 확장자 없이 Modelfile 이라고 만들어주면된다.

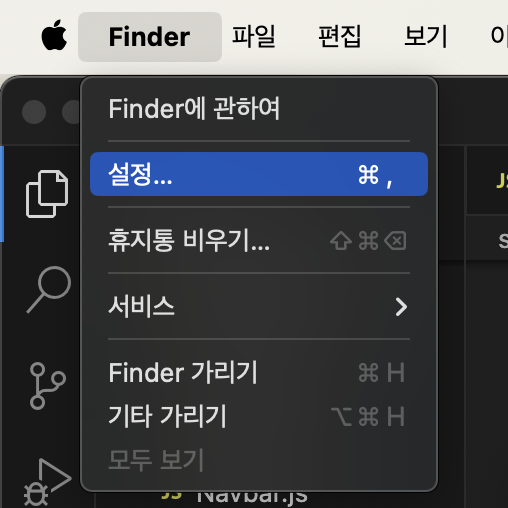

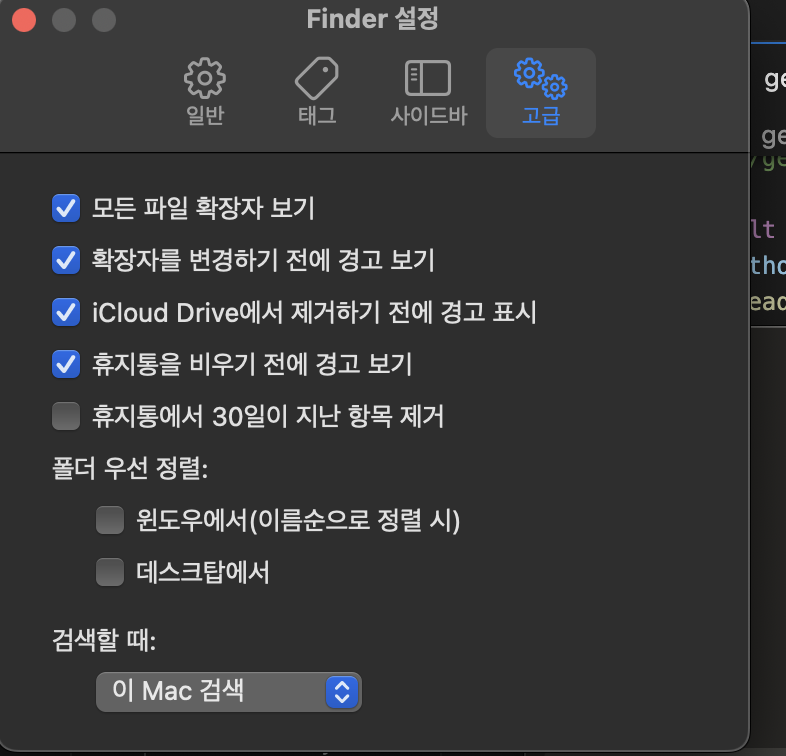

참고로 맥북의경우는 파일 확장자까지 나오게 설정해줘야하는데

아무 폴더에 들어가서 Finder -> 설정 -> 고급 에서 모든 파일 확장자 보기 설정을 해줘야한다.

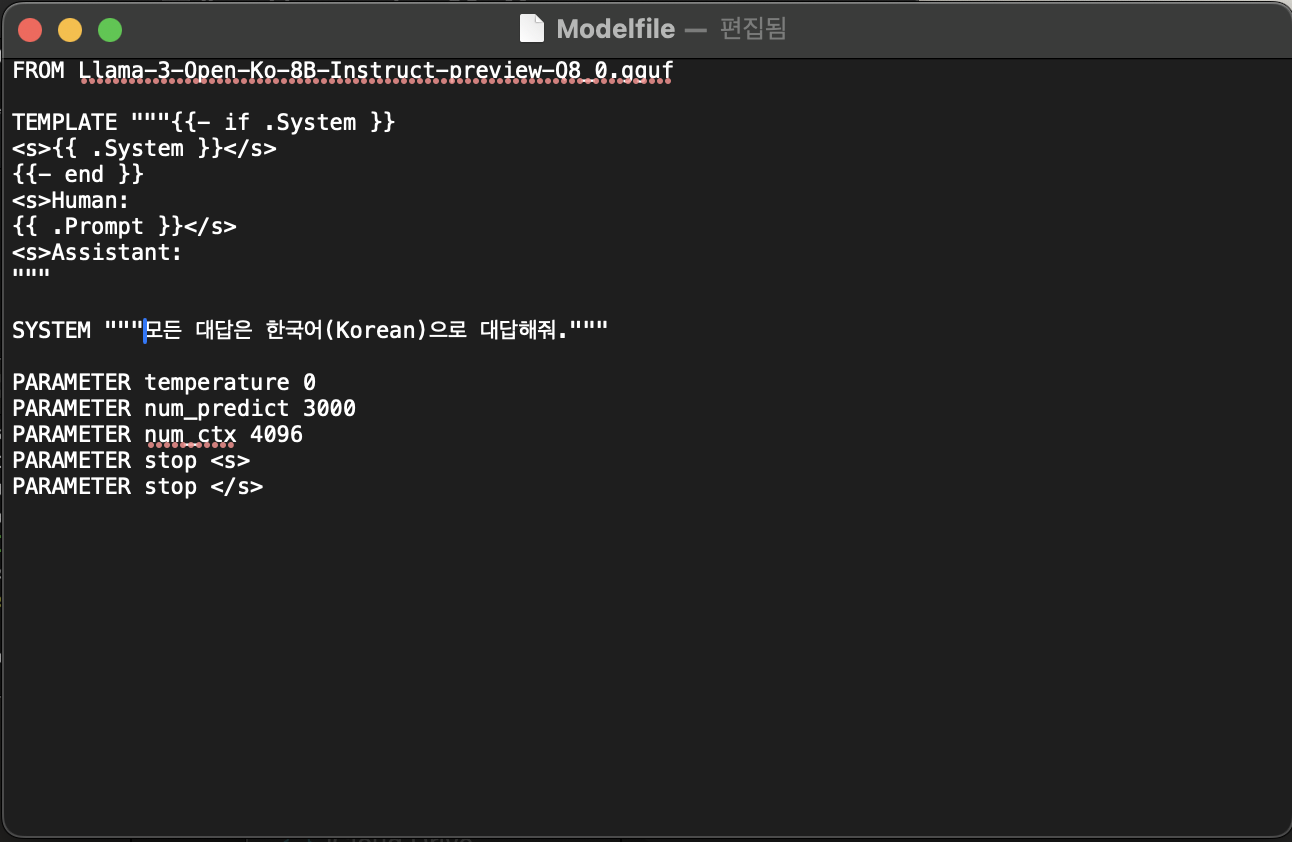

FROM Llama-3-Open-Ko-8B-Instruct-preview-Q8_0.gguf

TEMPLATE """{{- if .System }}

<s>{{ .System }}</s>

{{- end }}

<s>Human:

{{ .Prompt }}</s>

<s>Assistant:

"""

SYSTEM """모든 대답은 한국어(Korean)으로 대답해줘."""

PARAMETER temperature 0

PARAMETER num_predict 3000

PARAMETER num_ctx 4096

PARAMETER stop <s>

PARAMETER stop </s>이와같이 만들어주었다. 예제는 정말많아서 다른분들 글을 참고해도 좋다.

그리고 Modelfile과 다운로드받은 파일이 동시에 있는 곳에서 터미널로 아래 명령어를 입력한다.

ollama create eeve_gguf -f Modelfile

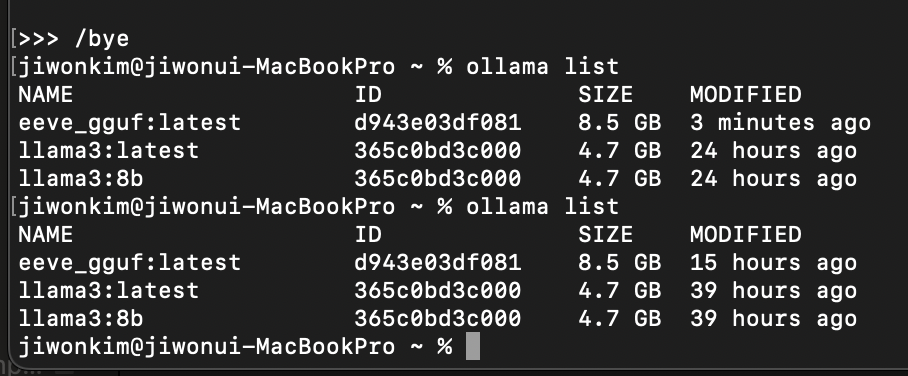

ollama list위와같이 명령어를 입력하면 현재 사용할 수 있는 모델리스트가 쭈욱나온다. 굳굳!

참고로 브라우저에 11434포트로 접속하면 이와같은 메세지도 볼 수 있다.

-참고한 링크

https://velog.io/@cathx618/Ollama%EC%97%90%EC%84%9C-HuggingFace-%EB%AA%A8%EB%8D%B8-%EC%82%AC%EC%9A%A9%ED%95%98%EB%8A%94-%EB%B0%A9%EB%B2%95-feat.EEVEhttps://www.propengi.com/%ED%97%88%EA%B9%85%ED%8E%98%EC%9D%B4%EC%8A%A4-%EB%AA%A8%EB%8D%B8-ollama%EC%97%90-%EC%B6%94%EA%B0%80%ED%95%98%EA%B8%B0/

'LLM, AI' 카테고리의 다른 글

| Ollama 사용해서 로컬 모델 구축하기 (Private GPT) (0) | 2024.06.22 |

|---|